Anwendungen: Make JUPITER shine

Anwendungen sind ein zentraler Aspekt in der Exascale-Strategie des Jülich Supercomputing Centres (JSC). Konkrete Anwendungsfälle, die auf JUPITER berechnet werden, haben das Potenzial, Entwicklungen in wichtigen gesellschaftlichen Bereichen voranzutreiben und insbesondere den Wandel durch die enorme Gesamtrechenleistung von JUPITER erheblich zu beschleunigen. JUPITER wird mehr als 1 ExaFLOP/s bei Berechnungen mit doppelter Genauigkeit und mehr als 70 ExaFLOP/s bei 8-Bit-Genauigkeit erreichen, was insbesondere für KI-Anwendungen relevant ist.

JUPITER Benchmark Suite

Anwendungen spielten eine wichtige Rolle im Beschaffungsprozess von JUPITER. Die JUPITER Benchmark Suite wurde entwickelt, um ein System in Betrieb zu nehmen, das nicht nur in synthetischen Benchmarks, sondern auch in realen und relevanten Anwendungsfällen sehr gut abschneidet. Basierend auf aktuellen und künftig wichtigen Anwendungen wurde eine Sammlung von 16 Anwendungen zusammengestellt und zur Leistungsbewertung möglicher Konfigurationen von JUPITER verwendet. Andreas Herten, Hauptautor der zugehörigen wissenschaftlichen Veröffentlichung, kommentiert:

„Mit der JUPITER Benchmark Suite haben wir einen Meilenstein für die a-priori-Evaluierung von Supercomputern geschaffen. Die Kombination aus Standardisierung und realen Anwendungen ist einzigartig und ermöglichte eine gezielte Vorhersage der zu erwartenden Leistung.“

JUPITER Research and Early Access Program

Für Anwendungen ist JUPITER nicht nur eine Chance, sondern auch eine Herausforderung. Um das volle Potenzial eines Supercomputers dieser Größenordnung auszuschöpfen, müssen Anwendungen sorgfältig vorbereitet und optimiert werden. Dies kann von der Anpassung von Algorithmen und Methoden bis hin zur Optimierung einzelner Einstellungen reichen. Solche Optimierungen werden derzeit im Rahmen des JUPITER Research and Early Access Program (JUREAP) durchgeführt. Im JUREAP arbeiten Expertinnen und Experten des JSC an mehr als 100 Anwendungen, um diese für das Exascale-Zeitalter zu bewerten und vorzubereiten. Die Anwendungen sind äußerst vielfältig und haben das Potenzial, zahlreiche wissenschaftliche Disziplinen grundlegend voranzubringen. Sie reichen von KI-Anwendungen wie Foundation Models und generativer Videogenerierung über Klimamodelle, Teilchenphysik und Energieanwendungen bis hin zu Molekulardynamik-Simulationen, die für die Medikamentenentwicklung und Krankheitsbekämpfung relevant sind. Einige Beispiele werden im Folgenden kurz vorgestellt.

Pionierarbeit im Exascale-Bereich

Ein weiterer wichtiger Meilenstein auf dem Weg zum Exascale-Computing war der GCS Exascale Pioneer Call. Dieser Call bot erstmals die Möglichkeit, sich mit Anwendungen um Rechenzeit auf JUPITER zu bewerben. Dafür mussten die Anwendungen ihr Exascale-Potenzial unter Beweis stellen und ein überzeugendes Nutzungsszenario für das Exascale-Niveau präsentieren. Dies hatte auch Auswirkungen auf den Betrieb der aktuellen Supercomputer des JSC. Um den Exascale-Kandidaten faire Bedingungen zu bieten, ihre Leistungsfähigkeit auf einer großen Anzahl von GPUs zu demonstrieren, wurden am JSC regelmäßig sogenannte Big Days angeboten. Big Days sind eine einzigartige Gelegenheit, Supercomputer am JSC im maximalen Maßstab zu nutzen. Für den letzten Big Day im Oktober – kurz vor Ablauf der Einreichfrist für den GCS Exascale Pioneer Call – war die Nachfrage so groß, dass daraus fast eine „Big Week“ wurde. Insgesamt zeigt sich das JSC sehr zufrieden mit den Vorbereitungen wichtiger Exascale-Anwendungen. Mathis Bode, Leiter von JUREAP, fasst zusammen:

„Obwohl die Bewertung der Anwendungen äußerst gründlich und streng war, überstieg die Nachfrage nach Rechenzeit durch geeignete Anwendungen das Angebot deutlich. Wir sind mit den Anwendungen sehr zufrieden und freuen uns darauf, sie weiter für JUPITER vorzubereiten – und letztlich das volle Potenzial von JUPITER zu entfalten.“

JUPITER Anwendungsfälle

Biologie - Biophysik

Prof. Dr. Gerhard Hummer, Direktor der Abteilung Theoretische Biophysik, Max-Planck-Institut für Biophysik

Wir nutzen biomolekulare Simulationen und Modellierungen, um zu erforschen, wie biologische Systeme auf molekularer Ebene funktionieren. Damit verbessern wir unser Verständnis davon, wie lebende Zellen arbeiten – als Grundlage für neue Therapien und Anwendungen in der Nanotechnologie. Mit JUPITER wollen wir Molekulardynamik-Simulationen des Kernporenkomplexes durchführen – des größten Proteinkomplexes in Zellen –, um zu entschlüsseln, wie er den molekularen Transport reguliert. Diese Simulationen umfassen Hunderte Millionen Atome und benötigen Exascale-Rechenleistung, um relevante Zeitskalen zu erreichen. Exascale ermöglicht einzigartige atomare Einblicke, verbessert Modelle des nukleären Transports und ebnet den Weg für eine gezieltere Steuerung des Gentransports sowie den Kampf gegen Retroviren wie HIV.

Medizin – Zelluläre Neurowissenschaften

Prof. Dr. Katrin Amunts, Direktorin des Instituts für Neurowissenschaften und Medizin (INM-1) am Forschungszentrum Jülich

Unser Ziel ist es, ein großes Foundation Model des menschlichen Gehirns zu entwickeln. Exascale-Rechenleistung wird es uns ermöglichen, dessen komplexe Struktur bis hinunter auf die Ebene einzelner Zellen und ihrer Verbindungen abzubilden – präzise verankert in der Anatomie des Gehirns. Zum ersten Mal wird JUPITER es ermöglichen, den über Jahrzehnte hinweg gesammelten Schatz an Bilddaten mit Ergebnissen aus anderen bildgebenden oder optischen Verfahren mit mikroskopischer Genauigkeit zu verknüpfen. Dadurch können wir neue Erkenntnisse über den Zusammenhang zwischen Gehirnstruktur und -funktion gewinnen und ganz neue Perspektiven für die Erforschung der Beziehung zwischen der Architektur neuronaler Netzwerke und Intelligenz eröffnen.

Physik – Kern- und Elementarteilchenphysik, Quantenmechanik, Relativitätstheorie, Feldtheorien

Prof. Dr. Zoltan Fodor, Universität Wuppertal

Als Teilchenphysiker berechnen wir mikrophysikalische Größen, wie beispielsweise das magnetische Moment eines Elementarteilchens, dem sogenannten Myon. JUPITER wird mehr als zehnmal leistungsfähiger sein als sein Vorgänger, was es uns ermöglicht, die Auflösung unseres „Mikroskops“ erheblich zu erhöhen und eine bisher unerreichte Präzision zu erzielen. Die Ergebnisse dieser Berechnungen können mit aktuellen experimentellen Messungen verglichen werden. Sollten Abweichungen auftreten, hätte dies tiefgreifende Auswirkungen auf die grundlegenden Naturgesetze – etwa die Existenz eines bislang unbekannten Teilchens oder das Vorhandensein einer neuen Wechselwirkung.

Prof. Dr. Christoph Lehner, Universität Regensburg

Wir untersuchen die Physik von Quarks und Gluonen von sehr niedrigen bis hin zu sehr hohen Energien. Mit JUPITER steht uns erstmals eine Maschine zur Verfügung, die es erlaubt, Raum-Zeit-Boxen in einem ausreichend großen Maßstab zu studieren, dass sie gleichzeitig die langreichweitigen Skalen enthalten, auf denen Quarks und Gluonen gebunden sind, sowie die kurzreichweitigen Skalen, auf denen sie quasi frei sind. Ein solches Setup ermöglicht es, neue Observablen zu untersuchen, bei denen beide Aspekte eine wichtige Rolle spielen, und ist zudem entscheidend für eine hohe Präzision bei einigen unserer Forschungsziele im niedrigeren Energie-Bereich. Diese Arbeit ist nur mit einem Exascale-Supercomputer möglich, und wir freuen uns darauf, JUPITER voll auszunutzen, um dieses spannende neue Kapitel unserer Forschung aufzuschlagen.

Prof. Dr. Dr.h.c. Ulf-G. Meißner, Universität Bonn und Forschungszentrum Jülich

Zu verstehen, wie Kerne gebildet werden und wie schwere Elemente entstehen, gehört zu den noch ungelösten Problemen der fundamentalen Physik. Mit JUPITER wollen wir groß angelegte Simulationen unter Verwendung der nuklearen Gitter-Effektfeldtheorie durchführen, um die Grenzen der Kernstabilität zu erforschen, Kernreaktionen zu berechnen, die für die Elemententstehung relevant sind, und die Eigenschaften der dichtesten Objekte im Universum, nämlich Neutronensterne, zu untersuchen. Dies ist nur mit Exascale-Computing möglich, da eine große Anzahl beteiligter Teilchen und ausreichend große Volumen benötigt werden, um Gitterartefakte ausreichend zu unterdrücken. Darüber hinaus werden diese Methoden den Weg für verbesserte Materialsimulationen und die Gehirnforschung jenseits der Molekularfeldtheorie ebnen.

Prof. Dr. Kristel Michielsen, Leiterin der Forschungsgruppe Quanteninformationsverarbeitung am Forschungszentrum Jülich

UNified Infrastructure for Quantum Computing – JUNIQ am Jülich Supercomputing Centre:

„Wir führen groß angelegte Simulationen von Quantencomputern und Quantenannealern durch und benchmarken sowie untersuchen Prototyp-Anwendungen für diese neue Rechentechnologie. Mit JUPITER planen wir, einen universellen, gate-basierten Quantencomputer mit 50 Qubits zu emulieren sowie eine kompilierte Version von Shors Algorithmus und das Quantenannealing des Hubbard-Modells auf einem solchen Quantencomputer durchzuführen. Da die GH200 Superchips von JUPITER den CPU- und GPU-Speicher sowohl für GPU als auch CPU jedes Chips zugänglich machen, ist es möglich, die verfügbare Speichermenge effektiv zu verdoppeln, was uns erlaubt, den Weltrekord mit 50 Qubits aufzustellen. Simulationen von Quantencomputern dieser Größenordnung ermöglichen es, die Leistungsfähigkeit potenzieller Anwendungen zu untersuchen, die die Gesellschaft nachhaltig beeinflussen werden.“

Physik – Statistische Physik, Weiche Materie, Biologische Physik, Nichtlineare Dynamik

Prof. Dr. Gerhard Gompper, Direktor des Instituts IAS-2 – Theoretische Physik lebender Materie – am Forschungszentrum Jülich und Fakultätsmitglied des Instituts für Biologische Physik an der Universität zu Köln

Wir untersuchen das Verhalten biologischer Flüssigkeiten, etwa von Blutzellen im Blutstrom, sowie aktiver Mikroorganismen – z. B. Bakterien, Algen und Spermien – in fluiden Umgebungen.

Bei letzteren Systemen führt die gerichtete und selbstgesteuerte Schwimmbewegung der Organismen zu einer Vielzahl dynamischer Selbstorganisationen, wie etwa maritimen Algenblüten oder bakterieller Turbulenz, bei denen Strukturbildung auf Längenskalen auftritt, die die Größe der Mikroorganismen um ein Vielfaches übersteigen.

Solche Simulationen erfordern eine enorme Rechenleistung, wie sie nur Exascale-Computer wie JUPITER bereitstellen können.

Unsere Studien könnten zur Entwicklung schwärmender Mikroroboter beitragen und Anwendungen in der Biotechnologie, etwa für Kohlenstoffbindung oder Biotreibstoffe, ermöglichen.

Physik - Astrophysik und Astronomie

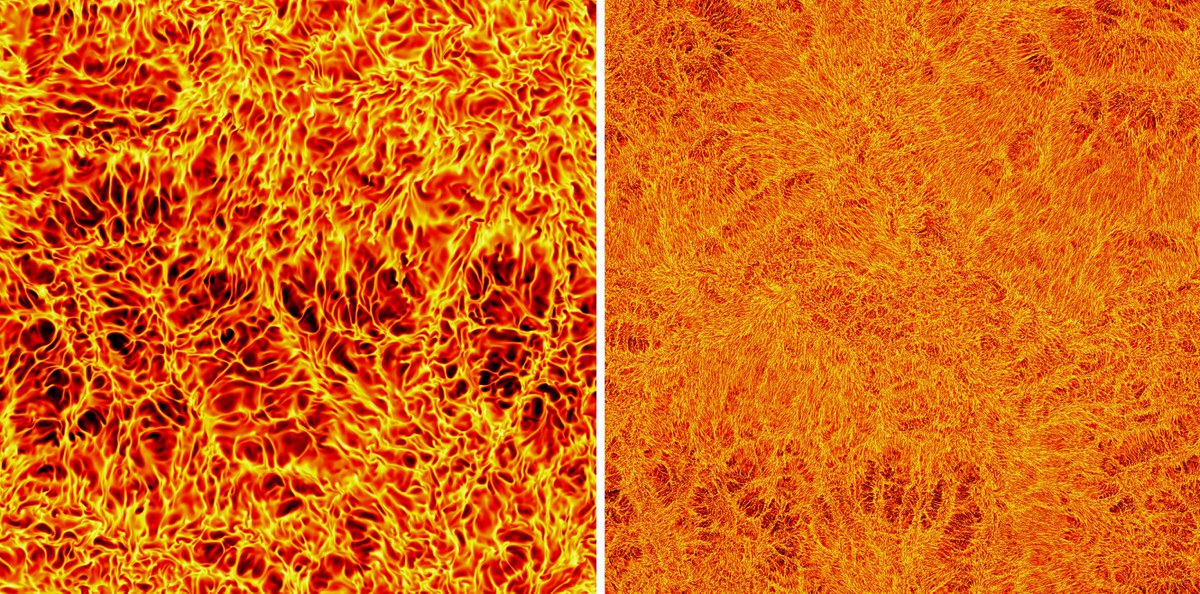

Prof. Dr. Marcus Brüggen, Professor für Extragalaktische Astrophysik an der Universität Hamburg

Wir befassen uns mit den fundamentalen Eigenschaften magnetisierter Turbulenz. Mit JUPITER wollen wir die bisher größte Magnetohydrodynamik-(MHD)-Turbulenzsimulation durchführen, um herauszufinden, ob ein asymptotisches Verhalten existiert – und wenn ja, wie es aussieht. Diese Simulation ist nur mit Exascale-Ressourcen realisierbar, da sie einen extrem großen dynamischen Bereich erfordert – verbunden mit bisher unerreichten Anforderungen an Rechenleistung, Speicher und Datenvolumen. Wir sind gespannt, ob die Ergebnisse bestehenden Theorien entsprechen oder ob völlig neue Ansätze erforderlich sein werden – gestützt auf hochauflösende Daten und mit möglichem Beitrag zur Fusionsforschung, um langfristig Lösungen für die Energiekrise zu finden.

Physik - Numerische Strahlenphysik (Computational Radiation Physics)

Dr. Michael Bussmann, Helmholtz-Zentrum Dresden-Rossendorf

Wir untersuchen die Kompression von Hochenergieplasmen mithilfe von Petawatt-Lasern und Megagauss-starken Magnetfeldern, um neue Wege zur Steigerung der Energiedichte bei lasergetriebener Kompression zu erforschen. Mit JUPITER werden wir Particle-in-Cell-Simulationen mit PIConGPU durchführen, um umfassende Parameterstudien und Stabilitätsanalysen zu ermöglichen, die die experimentellen Umsetzungen durch ein fundiertes theoretisches Verständnis untermauern. Exascale-Computing ist unerlässlich, um diese Simulationen mit realistischen, räumlichen Auflösungen durchzuführen und Signale komplexer synthetischer Diagnostiken zu berechnen. Diese ermöglichen es, die Lücke zwischen experimentellen Ergebnissen und einem umfassenden theoretischen Verständnis zu schließen. Diese Forschung kann entscheidende Einblicke in die Physik von Materie unter extremen Dichten und Temperaturen liefern – mit Anwendungen in der Astrophysik und der Laserfusion.

Geowissenschaften – Atmosphärenwissenschaften

Dr. Daniel Klocke, Max-Planck-Institut für Meteorologie

Der Klimawandel stellt unsere Gesellschaft vor tiefgreifende Fragen – und eröffnet zugleich faszinierende wissenschaftliche Rätsel. Im Zentrum dieser Fragen steht das Zusammenspiel zwischen kleinen und großen Skalen: Beeinflussen Stürme das globale Windmuster? Und was lässt sich aus dem globalen Windmuster über einzelne Stürme sagen? Früher schienen diese Rätsel unlösbar, da die dafür notwendigen Skalen rechnerisch nicht abbildbar waren. Doch mit JUPITER beginnt ein neues Kapitel: Zum ersten Mal können wir das globale Klima mit lokaler Detailgenauigkeit simulieren – ein gewaltiger Fortschritt für die Klimaforschung. Die Lösung dieser Rätsel wird der Gesellschaft helfen zu beantworten, welche Veränderungen im Klima unausweichlich sind – und wie wir uns am besten darauf vorbereiten können.

Dr. Nils Peter Wedi, Leiter Digitale Technologie von Destination Earth am Europäischen Zentrum für mittelfristige Wettervorhersage (ECMWF)

Supercomputing ist eng verbunden mit unserer Fähigkeit, Wetterextreme in einem sich erwärmenden Klima genau zu simulieren und regionale sowie lokale Veränderungen in unserer Umwelt zu prognostizieren. Gemeinsam mit Forschenden aus zahlreichen europäischen und nationalen Institutionen setzen wir „Destination Earth“ um – extrem großskalige digitale Zwilling-Simulationen unseres Erdsystems, genau für diesen Zweck. Wir freuen uns, Europas größten Supercomputer JUPITER direkt in der Nähe unseres neuen Campus in Bonn zu haben. Diese Exascale-Rechenressourcen sind notwendig, um uns quantitative Unsicherheitsgrenzen zu liefern und die Entscheidungsfindung für eine Reihe von Anpassungsmaßnahmen in Bereichen wie Landwirtschaft, Gesundheit und Energie zu unterstützen.

Thermische Verfahrenstechnik / Verfahrenstechnik – Strömungsmechanik

Prof. Dr. Andrea Beck, stellvertretende Direktorin des Instituts für Aerodynamik, Universität Stuttgart

Die Reduzierung des ökologischen Fußabdrucks des Luftverkehrs erfordert radikal neue Designideen für Flugzeugrümpfe und Antriebe, die durch ein tieferes Verständnis der komplexen Strömungsphysik angetrieben und ermöglicht werden. JUPITER wird es uns ermöglichen, das gekoppelte Problem der Schock-/Grenzschicht-Interaktion an einem Flügel unter realistischen Flugbedingungen durch extrem detaillierte Simulationen zu untersuchen, die alle relevanten Wechselwirkungen auflösen – dies ist nur auf einem Exascale-System möglich, da ein sehr großer Bereich an Längen- und Zeitskalen berücksichtigt werden muss. Durch die Simulationen auf JUPITER werden wir diese Strömungen verstehen und vorhersagen können: Ein entscheidender Schritt zur Entwicklung saubererer, leiserer und sichererer Flugzeuge.

Prof. Dr.-Ing. Christian Hasse, Leiter der Abteilung Simulation reaktiver thermo-fluiddynamischer Systeme an der Technischen Universität Darmstadt

Der Ersatz fossiler Brennstoffe durch Wasserstoff, beispielsweise in der CO₂-freien Stromerzeugung, ist entscheidend für das Erreichen von Netto-Null-Emissionen. Die Dynamik turbulenter, unter Druck stehender Wasserstoffflammen unterscheidet sich jedoch erheblich von der konventioneller Brennstoffe und ist bislang nur unzureichend verstanden. Exascale-Supercomputing treibt den Fortschritt in der Grundlagenforschung voran und ermöglicht es uns, die Komplexität der Wasserstoffverbrennungsdynamik durch direkte numerische Simulation (DNS) zu entschlüsseln. Wir können jetzt die kürzesten Zeitskalen bis hinunter zu Nanosekunden auflösen und turbulente Flammenstrukturen im Mikrometerbereich erfassen. Mit JUPITER ermöglicht das Exascale-Computing erstmals DNS unter technisch relevanten Gasturbinenbedingungen – ein Meilenstein in das Computational Engineerung und die Prozessvirtualisierung.

Prof. Dr. Jörg Schumacher, Leiter des Fachgebiets Strömungsmechanik an der TU Ilmenau

Auftriebsgesteuerte turbulente Konvektionsströmungen sind in Natur und Technik allgegenwärtig – von Sterneninneren bis hin zur Blanket-Kühlung in Kernfusionsreaktoren. Die Rayleigh-Bénard-Konvektion, eine ebene Flüssigkeitsschicht zwischen zwei Platten, die von unten gleichmäßig erhitzt und von oben gekühlt wird, ist das Paradigma für all diese multiphysikalischen Prozesse. Der neue Supercomputer JUPITER wird uns die Möglichkeit geben, ein tieferes Verständnis der Dynamik der gekoppelten thermischen und viskosen Grenzschichten zu gewinnen, die den globalen Wärmetransport bestimmen. Die kommende Generation von Exascale-Berechnungen wird beispiellose Details über die Strukturen in der natürlichen Konvektion und deren Zusammenhang mit statistischen Fluktuationen der Felder auf bisher unerreichtem Turbulenzniveau offenlegen.

Computer Science, Systeme und Elektrotechnik – Interaktive und intelligente Systeme, Bild- und Sprachverarbeitung, Computergrafik und Visualisierung

Prof. Dr. Björn Ommer, Leiter der Computer Vision und Learning Gruppe an der LMU München

Unsere Forschung konzentriert sich auf Foundation Models für die Videodarstellung und -erzeugung, inspiriert vom Erfolg generativer Ansätze wie Stable Diffusion. Durch JUPITER wollen wir spatio-temporale Kompressions- und Diffusionsarchitekturen entwickeln, die die Erstellung hochwertiger und zugänglicher Videomodelle ermöglichen. Exascale-Computing spielt dabei eine entscheidende Rolle, da es uns erlaubt, mit großen Datensätzen zu trainieren und gleichzeitig die Effizienz der Modelle zu optimieren. Dieser Ansatz eröffnet spannende Möglichkeiten zur Entwicklung von Videomodellen, die weit über ihre Trainingsdaten hinaus generalisieren können. Solche Modelle haben das Potenzial, gesellschaftliche Auswirkungen in verschiedenen Bereichen zu erzielen – von der Weiterentwicklung der medizinischen Bildgebung bis zur Verbesserung des autonomen Fahrens – und gleichzeitig Zugänglichkeit und Innovation zu fördern.

Kontakt

Dr. Andreas Herten

Co-Lead of division Novel System Architecture design, head of ATML Accelerating Devices

- Jülich Supercomputing Centre (JSC)

Raum 228